Dies ist eine alte Version des Dokuments!

Die Darstellung von ganzen Zahlen

Ein Mikroprozessorsystem verarbeitet immer Bitmuster in Einheiten zu 8, 16, 32 oder mehr Bit. Erst durch die Art der Verarbeitung wird diesem Bitmuster eine bestimmte Bedeutung zugewiesen. Wende ich einen arithmetischen Maschinenbefehl auf ein Bitmuster an, so wird es als Zahl interpretiert, eine Ausgabe auf den Bildschirm interpretiert das gleiche Bitmuster dagegen als darstellbares Zeichen des aktuellen Zeichensatzes.

Beispiel: Ein Byte hat den Inhalt 01000011b = 43h = 67d

Das kann unterschiedlich interpretiert werden.

- ASCII-Zeichen 'C'

- Vorzeichenlose oder vorzeichenbehaftete 8-Bit-Zahl: 67d = 43h

- als Maschinenbefehl

- Bitmuster um die Interrupts 0,1 und 6 freizugeben

Hier geht es um die Interpretation von Bitmustern ganze Zahlen betrachten.

Ein Mikroprozessor kann ein Bitmuster als Zahl interpretieren, dabei wird nach ganzen Zahlen mit und ohne Vorzeichen sowie Fließkommazahlen unterschieden.

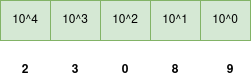

Um die Darstellung der ganzen Zahlen zu verstehen, betrachten wir zunächst das uns geläufige Dezimalsystem , in dem zehn verschiedene Ziffern mit Potenzen der Zahl 10 gewichtet werden: